Après une année 2024 marquée par des investissements stratégiques et une consolidation de ses activités, Divalto présente ses résultats.

L’intelligence artificielle (IA) a émergé comme l’une des avancées technologiques les plus significatives de notre époque. Depuis ses premières conceptualisations, l’IA a connu une évolution rapide, passant de simples algorithmes à des systèmes capables d’apprendre et de s’adapter. Aujourd’hui, l’importance de l’IA est indéniable, influençant des secteurs aussi variés que la santé, la finance, l’éducation et même l’art.

Société

04 juillet 2024 –

18 mn de lecture

Tout le monde parle de l’IA, pense connaître plus ou moins l’IA, utilise l’IA. C’est un domaine qui existe depuis de nombreuses années mais longtemps limité par les capacités de calcul. Aujourd’hui, les machines sont de plus en plus puissantes et les capacités de calcul permettent à l’IA de progresser de plus en plus rapidement. Mais les capacités techniques seules ne suffisent pas ! Il faut également avoir accès à un grand nombre de données pour que l’IA puisse apprendre. Aujourd’hui, les réseaux et le partage des données sont suffisamment développés et bien alimentés pour permettre de passer à la vitesse supérieure, en particulier pour l’IA générative, la plus spectaculaire des IA, qui évolue à un rythme effréné.

Mais que savons-nous réellement de l’IA ? D’où vient l’IA et qui l’a inventée ? Quels sont les différents types d’IA et quel est leur impact ? Faisons un petit tour d’horizon pour bien comprendre de quoi nous parlons.

L’intelligence artificielle (IA) a longtemps été un domaine de la recherche informatique avant de se démocratiser. L’IA a pour but de créer des systèmes ayant la capacité d’effectuer des tâches qui nécessitent normalement de faire appel à l’intelligence humaine. L’origine de l’IA remonte aux années 1940 avec les premiers programmes informatiques capables de résoudre des problèmes de logique et de mathématiques.

Le mathématicien Alan Turing fut le premier dans les années 1950 à avoir anticipé que des algorithmes associés à de puissantes machines mèneraient forcément à l’intelligence artificielle et à des questions sur le statut de l’intelligence. C’est ce qui l’amena d’ailleurs à mettre au point le test de Turing, censé différencier un humain d’une machine. Il a aussi prédit que le test ne fonctionnerait plus lorsque les machines seraient suffisamment puissantes.

En 1956, John McCarthy annonce officiellement la création d’une nouvelle discipline nommée « intelligence artificielle ». Pendant les décennies suivantes, les chercheurs ont développé de nombreuses méthodes pour simuler l’intelligence humaine, en particulier l’apprentissage automatique, les réseaux de neurones, la logique floue et les systèmes experts.

Dans les années 1990 et 2000, l’IA a bénéficié de la croissance exponentielle des capacités des ordinateurs ainsi que des données disponibles. Des grandes entreprises telles que Google, Microsoft et IBM ont investi massivement dans la recherche en Intelligence Artificielle, ce qui a conduit à des avancées importantes dans des domaines tels que la reconnaissance vocale, faciale, d’images et la compréhension du langage naturel.

Aujourd’hui, l’IA est utilisée dans de nombreux domaines, de la médecine à la finance en passant par les transports. Les progrès continus dans ce domaine promettent de révolutionner encore davantage notre vie quotidienne dans les années à venir.

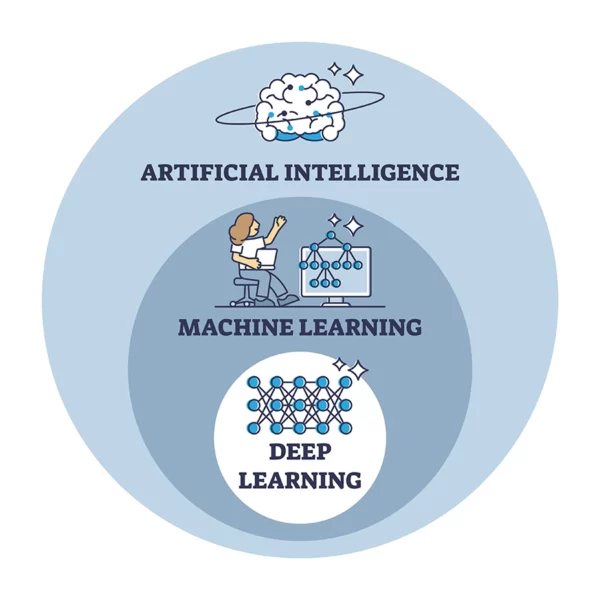

Le machine learning est une sous-partie de l’IA, bien qu’ils soient intimement liés. Le machine learning est un ensemble de processus qui permet d’apprendre et de s’améliorer automatiquement à partir d’un gros volume de données, en se basant sur des algorithmes. Les données utilisées doivent être structurées ou semi-structurées, ce qui peut impliquer que des experts préparent d’abord ces données dans le format adéquat. Plus le modèle est utilisé et entrainé, plus les résultats sont probants.

Le machine learning se fait en apprentissage supervisé ou non supervisé. Dans le premier cas, on lui donne un jeu de données en lui indiquant, dès le départ, la réponse attendue. Cela permet d’apprendre et de s’améliorer par les probabilités et les statistiques, par exemple pour prédire si une machine va tomber en panne. En apprentissage non supervisé, la machine ne connait pas la réponse attendue. Elle va créer elle-même des classifications homogènes, selon ses propres critères. Par exemple, on peut l’utiliser pour trouver une segmentation client.

Les applications du machine learning sont nombreuses et existent depuis de nombreuses années : prédiction de résultats sportifs, gestion de la chaine logistique d’approvisionnement, maintenance prédictive, offres de voyages, prévisions en matière de vente, …

Le machine learning peut se faire sur un ordinateur classique et la machine peut apprendre avec une quantité limitée de données. Et aboutir à des résultats probants, contrairement au deep learning.

Le deep learning est une sous-catégorie du machine learning. Il utilise des réseaux de neurones profonds, organisé en plusieurs couches, d’où le nom de « profond ». On parle de neurones car le système est non linéaire et se rapproche du fonctionnement du cerveau. La complexité des réseaux permet d’apprendre et d’analyser des concepts beaucoup plus abstraits. Cela lui permet aussi d’apprendre à partir de données brutes, l’intervention humaine n’est donc pas nécessaire. En contrepartie, le deep learning nécessite une quantité de données extrêmement importante mais également des capacités de calcul hors norme. Plus le nombre de couches est grand, plus le besoin de données est important. Les concepts acquis sont abstraits et d’une grande finesse.

C’est l’accès au cloud qui a permis de développer le deep learning. Les ressources nécessaires sont très grandes, à la hauteur des résultats : le deep learning permet d’effectuer des tâches très complexes telles que la reconnaissance vocale ou faciale, la traduction automatique ou la génération de textes. On comprend pourquoi certains leaders de la technologie se lancent dans une course effrénée pour proposer aux acteurs de l’IA des semi-conducteurs puissants, des serveurs et l’énergie nécessaire pour faire tourner les datacenters. Ils sont les pendants des fournisseurs de pelles et de pioches lors de la ruée vers l’or 😉.

C’est un modèle d’apprentissage de deep learning, qui se base sur une immense base de données de textes pour son apprentissage en mode semi-supervisé ou non supervisé, souvent les données en ligne sur Google. Pendant l’apprentissage, le LLM engrange un nombre incroyable de données. Il est capable de comprendre, générer et manipuler le langage humain de manière très sophistiqué. Les anciens modèles fonctionnant par apprentissage supervisés étaient limités à une spécialité. Les LLM ont libéré les capacités d’apprentissage. C’est le cœur des IA génératives. Le modèle le plus célèbre est GPT, développé par OpenAI et utilisé dans l’agent conversationnel ChatGPT et Copilot de Microsoft. Il existe d’autres LLM tels que BERT développé par Google AI (adapté en français sous le nom de CamenBERT et FlauBERT), LLAMA pour Meta et Mistral développé par l’entreprise française Mistral AI.

C’est une approche informatique d’analyse basée non pas sur Vrai ou Faux mais sur un gradient de valeurs qui traduit des vérités partielles. Elle est utilisée dans de nombreux domaines pour parvenir à une conclusion. Par exemple elle permet d’améliorer des données imprécises, telles que des images ou des sons. Elle est utilisée en météorologie, dans le contrôle aérien, dans l’aide au diagnostic en médecine, etc.

Il s’agit en fait de l’instruction donnée à l’IA, en général sous forme de texte, pour la guider avec un maximum d’informations pour obtenir le résultat voulu. Cela semble anodin, mais de la maîtrise du prompt dépend la qualité du résultat. Parfois il faut itérer sur le même prompt plusieurs fois pour affiner le résultat, il faut préciser le contexte de la demande, etc. Nul doute que des formations pour acquérir les compétences nécessaires pour écrire des prompts efficaces vont apparaître !

Outre les mastodontes de la tech qui sont pour l’instant OpenAI, Google et Mistral, de nombreux autres acteurs développent chacun de leur côté des applications d’IA plus spécifiques, destinées à des métiers particuliers comme dans le domaine juridique, médical, le transport, etc. Certains d’entre eux développent leur propre LLM et leurs propres algorithmes et d’autres vont rassembler un certain nombre d’IA différentes sous une seule application pour que tous les besoins de l’utilisateur soient satisfaits avec un maximum de simplicité.

L’offre est pour l’instant complexe et changeante, mais nul doute que certaines d’entre elles vont émerger dans les années à venir et s’imposer en tant que leader. Certaines seront open source, d’autres payants, d’autres généralistes, d’autres seront spécialisés sur des niches.

Par définition, l’intelligence artificielle (IA) est un domaine de l’informatique qui vise à automatiser et améliorer des processus cognitifs. Il existe de nombreux secteurs d’activité utilisant l’IA qui ne soient pas génératives, comme par exemple, les IA qui permettent de :

Ces modèles d’IA issus du machine learning existent depuis de nombreuses années et sont utilisés couramment, sans même que nous nous en rendions compte.

La plus impactante des IA est sans conteste l’IA générative. En effet, depuis 2022, on parle beaucoup d’IA générative avec la mise en ligne de logiciels IA au grand public tels que ChatGPT ou Copilot qui utilisent des modèles de langage LLM récents. L’intelligence artificielle générative (IAG ou IAGen ou GenIA) est un sous-domaine de l’IA qui utilise des algorithmes pour générer de nouvelles données à partir de l’apprentissage de données existantes. Les modèles génératifs peuvent être utilisés pour créer de nouvelles images, sons, textes et autres types de données qui ressemblent aux exemples dont ils s’inspirent, mais qui sont différents de ceux-ci. On peut dire que l’IAG est créative.

En résumé, l’IA est un domaine plus large qui englobe de nombreuses techniques et applications, tandis que l’IAG est un sous-domaine spécifique de l’IA qui se concentre sur la génération de nouvelles données.

L’apparition de l’IA, et de manière plus spectaculaire l’IA générative, aboutira à une révolution dans le monde du travail. Nous n’en sommes qu’au tout début, les leaders d’aujourd’hui ne sont pas forcément ceux de demain et il est difficile de faire des pronostics sur l’avenir. Les nouveautés n’en finissent pas de sortir, que ce soit pour créer des images, des vidéos, des textes, des enregistrements audios …. à partir de prompts différents : texte, vocal, image, etc.

Aujourd’hui l’adoption de l’IA est extrêmement rapide, sans doute parce que c’est simple d’utilisation et très utile. Il suffit de constater la vitesse faramineuse avec laquelle l’outil a été adopté par les particuliers mais surtout les professionnels. Par exemple, le leader incontesté actuel de l’IA générative, ChatGPT, a atteint les 1 millions d’utilisateurs en 5 jours et 100 millions d’utilisateurs en 2 mois ; là où Instagram a mis respectivement 2,5 mois et 30 mois et Spotify a mis respectivement 5 mois et 55 mois ! Soit 15 à 30 fois plus longtemps !

En entreprise, 72 % des dirigeants de TPE/PME de France n’utilisent pas les IA génératives selon une étude BPI, alors que leurs collaborateurs semblent les utiliser plus facilement, parfois sans en informer leur hiérarchie. Les adeptes de l’IA en entreprise vont d’ailleurs plus vite que les services RH et IT, qui peinent à délivrer des chartes d’utilisation de l’IA tant cela va vite dans la sphère professionnelle.

Une chose est certaine, l’utilisation de l’IA en entreprise va se généraliser dans les années à venir, tout simplement parce que les avantages sont bien plus grands que les freins. Les spécialistes nous affirment que le gain de temps ou d’énergie pourrait avoisiner les 20 ou 30 %, parfois plus. En réalité, la révolution de l’IA vient seulement de commencer et il est difficile de connaitre le ROI exact de l’IA. C’est d’ailleurs l’une des raisons qui explique que les Directions d’entreprises restent prudentes et cherchent encore la meilleure façon d’investir. D’autre freins à l’adoption des dirigeants peuvent se trouver dans l’âge : les firsts adopters sont les jeunes : les 18-24 sont 40 % à avoir un très bon niveau dans l’utilisation de l’IA, contre 22 % chez les 45-54 ans selon une étude Hostinger. De plus, la vitesse des changements dans le monde de l’IA générative actuelle peine à donner certitudes et visibilité aux dirigeants et aux gestionnaires d’entreprise.

Une chose est sûre : le futur des entreprises se fera avec l’IA et ceux qui refuserons de l’adopter finirons sans doute par rester sur le bas-côté de la route. Mais nul doute que l’enthousiasme est très fort, et qu’à terme, que ce soit par les dirigeants ou les collaborateurs, l’IA fera son entrée dans les entreprises.

Selon une étude McKinsey, l’IA générative aura un impact sur l’ensemble des services de l’entreprise mais quatre services pourraient représenter environ 75 % de la valeur annuelle totale provenant des cas d’utilisation de l’IA générative. Ce sont le marketing et la vente, la R&D produit, le génie logiciel et les opérations clients. Les opportunités d’utilisation de l’IA dans ces services sont nombreuses et ont des effets très positifs, même si d’autres défis restent en suspens.

L’IA permet d’automatiser des tâches répétitives et fastidieuses et permet de libérer du temps pour des tâches plus créatives ou à plus forte valeur ajoutée. Par exemple, il est possible d’exploiter rapidement de très nombreuses données pour faire des prévisions de vente, d’approvisionnement, de logistique, de finance, créer un aperçu résumé d’un client, résumer des échanges de mails, préparer un rendez-vous client, créer des contenus …. L’IA permet aussi de repérer ou d’éviter les erreurs et d’optimiser les processus, ce qui réduit les coûts et les délais.

Si les collaborateurs peuvent se libérer des tâches fastidieuses pour se consacrer à des tâches plus intéressantes, ils seront reconnus pour leur travail à forte valeur ajoutée. Ils pourront se libérer de certaines routines, certaines pénibilités, certaines pressions, pour accéder à des responsabilités plus grandes et avoir plus de perspectives. Dans tous les cas, ils ressentiront davantage de satisfaction, d’estime de soi et de bien-être au travail.

L’amélioration des processus favorise le développement, la R&D et l’innovation, augmente la compétitivité et la croissance économique, en ouvrant de nouveaux marchés, de nouveaux secteurs et de nouvelles opportunités d’affaires.

L’IA ouvre aussi de nouvelles perspectives d’emploi et fait émerger de nouvelles filières métiers nécessitant de nouvelles compétences : des ingénieurs, développeurs, analystes, formateurs. Ce sera aussi l’occasion de reconversions professionnelles vers ces métiers. De nouveaux métiers seront aussi dédiés à l’entretien, au développement, à la maintenance de l’IA et de son environnement.

La plus grande peur et la plus grande inconnue concerne l’impact de l’IA sur certains métiers qui risquent d’être remplacés ou réduits, notamment ceux qui sont routiniers, peu qualifiés ou peu rémunérés. Ce qui entraîne des risques de chômage, de précarité ou d’inégalité sociale.

L’IA pose aussi des questions éthiques et juridiques concernant les droits d’usage, l’intégrité des données et les possibilités de discrimination, de violation de la vie privée, de la sécurité ou des droits de l’Homme. D’autre possibilités concernent les dommages causés par des systèmes d’IA autonomes ou non contrôlés.

Dans l’environnement de travail, l’IA peut éventuellement provoquer une sensation de déshumanisation ou de perte de sens. Elle peut aussi créer une sensation de stress, de surveillance et remettre en cause l’autonomie ou la créativité des travailleurs.

L’obligation de faire des investissements pour accéder à des infrastructures et des compétences spécifiques à l’IA risque de créer des inégalités selon la taille des entreprises et peut créer un fossé technologique et une concurrence déloyale.

Il existe également une inquiétude concernant l’impact environnemental car l’IA est une grande consommatrice d’énergie et de ressources.

Ces effets négatifs peuvent être évités ou atténués par des mesures appropriées, telles que la formation, l’accompagnement, la protection, la régulation ou la participation des travailleurs, afin de garantir que l’IA soit au service de l’humain et non l’inverse.

L’intelligence artificielle est un domaine en pleine expansion, qui offre de nombreuses opportunités et défis pour le monde du travail ainsi que dans la vie privée. Elle peut contribuer à améliorer la productivité, la créativité, l’innovation et la qualité des produits et services. Elle peut aussi favoriser l’inclusion, la diversité et l’équité dans les organisations.

Chez Divalto, l’IA est axée sur l’amélioration de l’expérience utilisateur. Notre engagement est d’utiliser l’IA pour enrichir et faciliter l’usage de nos solutions et apporter de la valeur ajoutée à nos utilisateurs là où ils en ont besoin. Notre volonté est de fournir une IA accessible et utile, qui répond aux besoins réels des entreprises sans les submerger de complexité.

Nous sommes convaincus que l’IA est un vrai catalyseur de progrès pour toutes les entreprises !

N’hésitez pas à contacter nos experts pour en savoir plus !

Après une année 2024 marquée par des investissements stratégiques et une consolidation de ses activités, Divalto présente ses résultats.

Le BtoB présente des défis spécifiques et une complexité accrue qui nécessitent des outils de gestion adaptés aux besoins des professionnels, notamment un ERP métier dédié.